Vecteur gaussien \((X_1,\dots,X_d)\)

Variable aléatoire à valeur dans \({\Bbb R}^d\) dont toute combinaison linéaire de ses élément suit une

Loi normale. $$\forall\lambda_1,\dots,\lambda_d,\quad\sum_{j=1}^d\lambda_jX_j\text{ est gaussienne}$$

- caractérisation : $${\Bbb E}[e^{i\xi\cdot X}]=\exp\left( i\xi\cdot m_X+\frac12\xi^TK_X\xi\right)$$ (via la Fonction caractéristique, avec \(m_X\) l'Espérance et \(K_X\) la Matrice de covariance, et \(\xi^TK_X\xi=\sum^d_{j,k=1}\xi_j\xi_k\operatorname{cov}(X_j,X_k)\))

- on écrit alors \(X\sim\mathcal N_d(m_X,N_X)\)

- propriété importante : si la Matrice de covariance est diagonale par blocs, alors les blocs sont indépendants

- si \((X_1,\dots,X_n,Y)\) est un vecteur gaussien centré, alors \({\Bbb E}[Y|X_1,\dots,X_n]\) est la Projection orthogonale (\(L^2\)) de \(Y\) sur \(\operatorname{Vect}\{X_1,\dots,X_n\}\)

- donc \(\exists\lambda_1,\dots,\lambda_n\in{\Bbb R}\), \({\Bbb E}[Y|X_1,\dots,X_n]=\sum^n_{j=1}\lambda_jX_j\) : la meilleure approximation de \(Y\) connaissant \(X_1,\dots,X_n\) est une combinaison linéaire de \(X_1,\dots,X_n\)

- de plus, \(\forall h:{\Bbb R}^n\to{\Bbb R}\) mesurable, \({\Bbb E}[h(Y)|X_1,\dots,X_n]\) est donnée par : $${\Bbb E}[h(Y)|X_1,\dots,X_n]=\int_{\Bbb R} h(y)q_\sigma\left( Y-\sum^n_{j=1}\lambda_j X_j\right)\,dy\quad\text{ avec }\quad \begin{cases} q_\sigma:z\mapsto\frac1{\sigma\sqrt{2\pi} }e^{-z^2/2\sigma^2}\\ \sigma^2={\Bbb E}[(Y-\sum_{j=1}^n\lambda_jX_j)^2]\end{cases}$$

- si \(m\in{\Bbb R}^d\) et \(K\) est une Matrice symétrique définie positive, alors on peut construire un vecteur gaussien \(X\sim\mathcal N_d(m,K)\)

- si \(X\) est un vecteur gaussien, alors sa loi est à densité si et seulement si \(K_X\) est inversible, et dans ce cas, la densité est : $$p(x)=\frac1{(2\pi)^{d/2}\sqrt{\operatorname{det} K_X} }\exp\left(-\frac12(x-m_X)^TK_X^{-1}(x-m_X)\right)$$

- si \(X\sim\mathcal N(m,\Gamma)\), alors \(\langle{X,u}\rangle \sim\mathcal N(\)$\langle{m,u}\rangle $$,$$u^T\Gamma u$$)\(

- si \)(u_1,\dots,u_d)\( est une Famille orthogonale, alors \)(\langle{X,u_i}\rangle )_{1\leqslant i\leqslant d}\( est une famille de v.a. Gaussiennes indépendantes 2 à 2

- de plus si leurs vecteurs propres associées sont \)(\sigma^2_i)_i\(, alors \)X=\( \)m+\sum^d_{i=1}\langle{X-m,u_i}\rangle u_i\(

- si \)(u_1,\dots,u_r)\( est une famille de vecteurs propres pour \)(\sigma_i^2)_i\( avec \)\sigma_i^2\gt 0\(, alors, en posant \)Z_i=\( \)\frac{X_i-m}{\sigma_i}\(, on a \)X=\( \)m+\sum^r_{i=1}\sigma_iZ_iu_i\(

- en particulier, \){\Bbb P}(X\in\;$$m+\operatorname{Im}(\Gamma)$$)=1\(

Questions de cours

START

Ω Basique (+inversé optionnel)

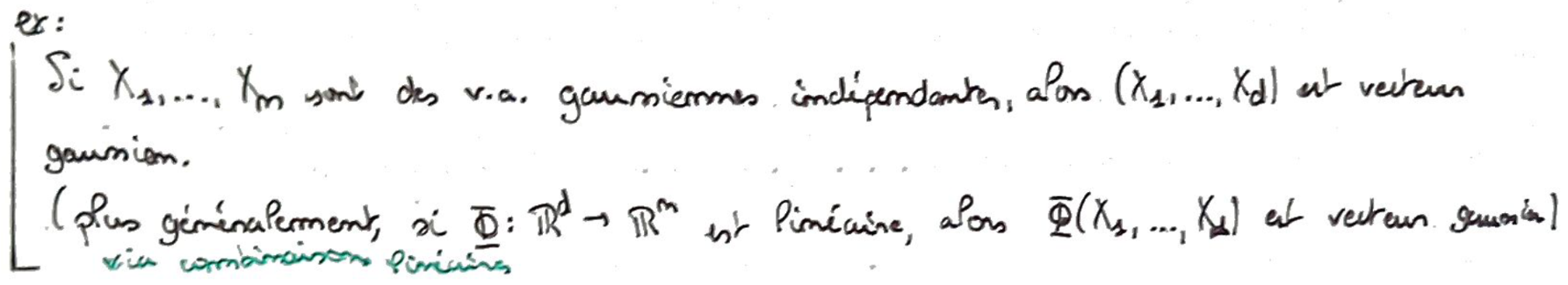

Recto: Donner un exemple de vecteur gaussien.

Verso:

Bonus:

Carte inversée ?:

END

START

Ω Basique (+inversé optionnel)

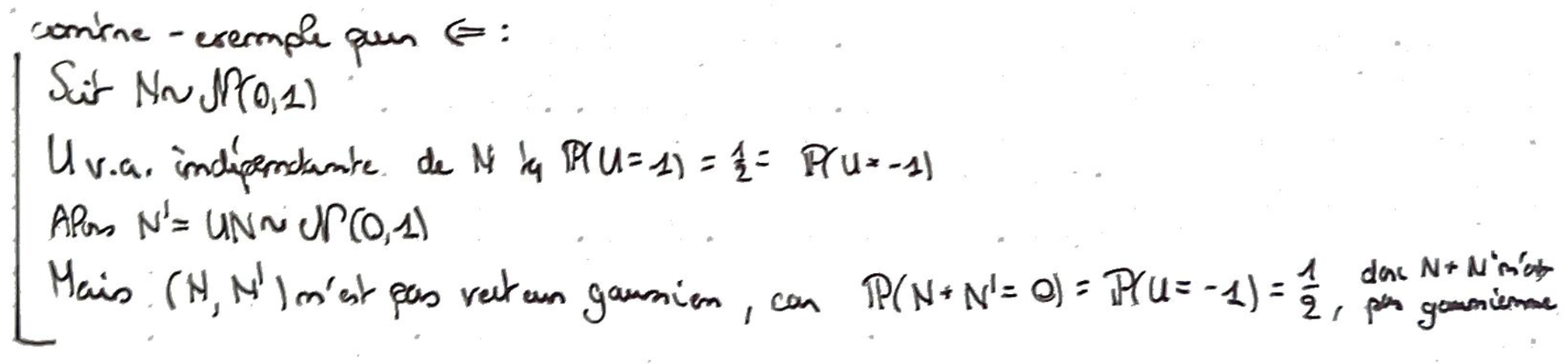

Recto: Donner un exemple de vecteur non gaussien dont toutes les composantes suivent une loi normale.

Verso:

Bonus:

Carte inversée ?:

END

START

Ω Basique (+inversé optionnel)

Recto: Expliquer pourquoi les vecteurs gaussiens sont intéressants en statistiques.

Verso:

- Via le rôle pivot des Loi normales (Transformée de Fourier, Théorème central limite)

- Via les interprétations des relations d'indépendancs en terme de géométrique euclidienne (Orthogonalité)

Bonus:

Carte inversée ?:

END

Exercices